基于深度强化学习的智能网络安全防护研究

摘 要:

人工智能(Artificial Intelligence,AI) 的快速发展为网络空间安全对抗提供了新的思路和 技术手段,然而 AI 在网络安全领域的应用将加剧网络攻防对抗的速度、烈度、复杂度。通过研究 基于深度强化学习的网络空间智能安全防护,探索了网络空间安全防御智能化问题的解决方法和 过程。此外使用深度学习提取网络安全态势数据特征,构建智能体,回报函数将网络攻击威胁度 作为奖惩引导学习,强化学习判断策略和动作好坏,通过在虚拟网络空间综合靶场训练学习获得 安全防护智能体和最优安全防护策略。

内容目录 :

1 深度强化学习基础理论

2 基于 DRL 的智能网络安全防护

2.1 状态集合设计

2.2 动作集合设计

2.3 回报函数设计

2.3.1 回报函数

2.3.2 基于动态贝叶斯的网络攻击威胁度评估

2.4 网络安全防护智能体训练过程

2013 年深度思考(DeepMind) 公司开发深度 学习和强化学习结合构建价值网络训练智能体挑战 雅达利 2600(Atari2600) 中的游戏。2016 年, 阿尔法围棋(AlphaGo)在围棋领域的成功是强 化学习领域的里程碑事件, AlphoGo 将深度学习和 强化学习结合构建价值网络和策略网络训练智能体,在对弈阶段采用蒙特卡洛树搜索。随后推出的阿尔法元(AlphaGoZero) 在 AlphaGo 的基础上将 策略网络和价值网络合并成一个深度神经网络进行 强化学习,在不使用已有知识经验的条件下自我训 练 3 天即击败 AlphaGo。Atari 游戏、围棋、国际 象棋都属于完美信息博弈,每个参与者可以在任何 时候看到已经发生或正在发生的游戏局势。2019 年,阿尔法星(AlphaStar)攻克即时战略游戏星际争 霸,智能体可以战胜 99.8% 的人类选手。星际争霸 是不完全信息下的博弈,主要使用了监督学习、深 度强化学习、基于循环神经网络(Recursive Neural Network, RNN)的局部马尔可夫决策,该智能体解决了不完全信息,需要远期计划,实时性以及多主 体博弈的难点问题。

DeepMind 团队取得的成绩推动了人工智能从 感知智能进入认知智能。感知智能以深度学习为代 表,认知智能以强化学习为代表。

强化学习的基本思想是从与环境的不断交互中 学习 , 根据从环境观测到的信息,做出行动决策, 然后观察环境反应调整行动,最终实现目标。网络空间安全攻防对抗过程中,攻防双方通过将攻击行为和防护行为作用于网络环境,并根据网络安全态 势的变化调整对抗策略,从而实现网络攻击和网络安全防护的目的,而强化学习为网络空间攻防对抗智能化提供了重要途径和技术手段。

本文主要研究强化学习的基础理论,针对网络 空间安全防护如何应用强化学习实现智能防护的问 题,提出初步解决方案。本文没有考虑网络攻击智 能化的问题。

01 深度强化学习基础理论

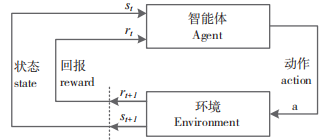

强化学习 (Reinforcement Learning,RL)以试错的机制与环境进行交互,通过最大化累积回报 学习最优策略。它是一种通过智能体 Agent 与环境 不断交互,获得最大累计期望回报,学习最优状态 到行动映射关系的方法。强化学习系统的原理如 图 1 所示。

图1 强化学习原理

强化学习系统通常包含 4 个元素:状态 s, 动作 a, 回报(Reward, 又称奖惩 / 奖励)r ,策略 π(a|s)。

状态空间 S:s ∈ S,状态集合。

动作空间A:a ∈A,动作集合。

累计期望回报 R 的计算方式为:

式中: γ ∈ [0,1] 为折扣因子表示未来某一时刻的奖 励在累计奖励中所占的影响比重;E 为 r 的数学期 望。强化学习目标是最大化累积回报期望,回报函 数是关键。

策略 π(a|s): 状态空间到动作空间的映射函数, Agent 依据策略 π(a|s) 生成动作 a。

时间序列 T:t ∈ T, t 表示当前时刻, t+1 表示 t时刻的下一时刻。

Agent 根据输入的环境状态  由策略 π(a|s) 选 取动作

由策略 π(a|s) 选 取动作 作用于环境, 环境状态转移至

作用于环境, 环境状态转移至 , 新的 环境状态

, 新的 环境状态 和动作执行回报

和动作执行回报 再次输入 Agent, Agent 评估策略 π(a|s) 优劣程度,进一步调整做出新 的决策。

再次输入 Agent, Agent 评估策略 π(a|s) 优劣程度,进一步调整做出新 的决策。

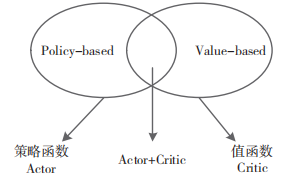

如 图 2 所 示,强 化 学 习 分 为 基 于值 函 数 (Value-based) 的 强 化 学 习 和 基 于 策 略 函 数 (Policy-based)的强化学习。

图 2 强化学习分类

行动者 - 评论家(Actor-Critic)算法结合了 两者优势, 其结构包括 Actor 策略函数和 Critic 值 函数。Actor 产生动作,Critic 评价动作好坏,并生 成 时 序差 分(Temporal Difference,TD)误 差 指 导 Actor 和 Critic 更新。Actor 策 略 函数 π(a|s) 和 Critic 值函数 (s,w) 通过神经网络学习获得。对于高维的 状态  和动作

和动作 数据,构建深度神经网络(Deep Neural Network, DNN)提取数据特征,学习策略 函数和值函数。

数据,构建深度神经网络(Deep Neural Network, DNN)提取数据特征,学习策略 函数和值函数。

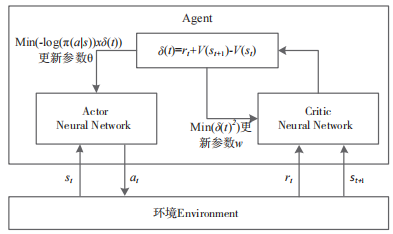

图 3 为 Actor-Critic 逻辑架构。图中,Actor 网 络使用环境状态 作为输入,输出动作

作为输入,输出动作 。Critic 网络计算动作最优价值, Actor 利用最优价值迭代 更新网络参数θ,进而选择新的动作作用于环境。Critic 使用环境反馈的回报

。Critic 网络计算动作最优价值, Actor 利用最优价值迭代 更新网络参数θ,进而选择新的动作作用于环境。Critic 使用环境反馈的回报 和环境新状态

和环境新状态 更 新网络参数 w ,然后使用新的参数 w 计算 Actor 输 出动作的最优价值。Critic 的评估点基于 TD 误差, TD 误差代表了估计值与目标值的误差大小,误差 越大样本的价值就越大。

更 新网络参数 w ,然后使用新的参数 w 计算 Actor 输 出动作的最优价值。Critic 的评估点基于 TD 误差, TD 误差代表了估计值与目标值的误差大小,误差 越大样本的价值就越大。

图 3 Actor-Critic 逻辑架构

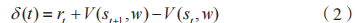

TD 误差的表达式为:

Critic 网络使用均方差损失函数作为参数 w 的 更新梯度,表达式为:

Actor 网络使用带权重的梯度更新策略网络参数θ,表达式为:

02 基于DRL的智能网络安全防护

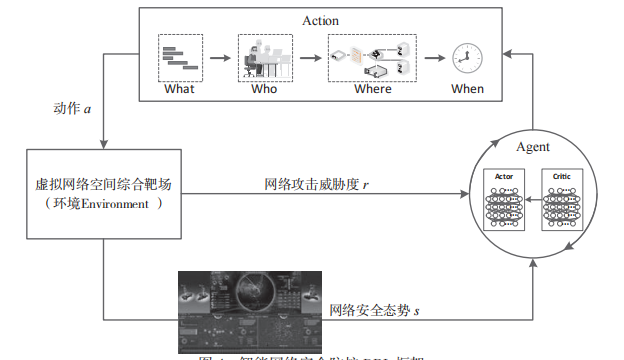

基于深度强化学习(Deep Reinforcement Learning, DRL)的网络安全防护智能体学习引擎使用虚拟化的网络空间综合靶场作为“环境(Environment) ”, 并通过 Actor-Critic 算法和深度神经网络构建 DRL 框 架,如图 4 所示。

虚拟网络空间综合靶场基于云计算平台构建,作 为实际网络的仿真运行环境 ,环境中的数据支持 从实际网络引入,从而使 Agent 的训练学习面向真实 环境。当把虚拟化网络空间综合靶场换做实际网络环 境时,Agent 可以直接使用不需要再做迁移学习。

图 4 智能网络安全防护 DRL 框架

2.1 状态集合设计

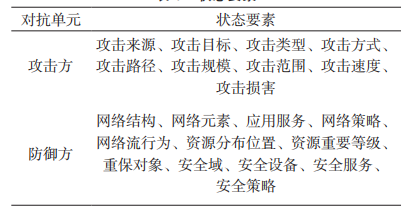

状态集合 S 是网络状态信息的集合,是网络状 态已知信息的客观描述数据,是强化学习的重要数 据。组成状态集合的状态要素分类如表 1 所示。

表 1 状态要素

表 1 中的状态要素是一个分类,每个分类有更 详细的原子状态信息,所有的原子状态信息共同构 成环境状态集合形成状态空间,例如:攻击对象原 子状态信息有计算机、网络路由器、网络交换机、 系统、服务,安全设备、工业设备等;计算机原子 状态信息有主机可访问状态,操作系统类型,操作 系统版本、权限、漏洞、存在脆弱性的服务和进程 等 ;攻击来源原子状态信息有 IP 地址,域名, AS 号等。

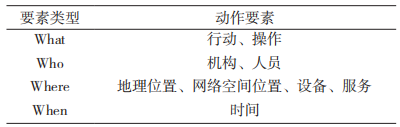

2.2 动作集合设计

动作集合A 是 Agent 可以采取的操作的集合, 策略 st+1 从动作集合中选取 at 执行。组成动作集合的动作要素分类如表 2 所示。

表 2 动作要素

表 2 中的动作要素是一个分类,每个分类有更 详细的原子动作,所有的原子动作共同构成动作集 合形成动作空间。

2.3 回报函数设计

2.3.1 回报函数

回报函数对强化学习的每步决策选择动作进行 奖励或惩罚,评判动作性能。回报函数对强化学习 过程起着导向作用,回报函数引导 Agent 在与环境 交互的过程中不断修正策略以选择价值回报最大的 动作。

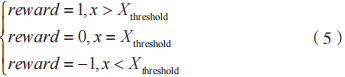

回报函数为:

Agent 选择动作 at 执行后,环境给出t 时刻网 络攻击威胁度 xt∈ X。如果 xt 大于阈值 Xthreshold, 进行正值反馈对 Agent 进行奖励;如果 xt 小于阈值 Xthreshold,进行负值反馈对 Agent 进行惩罚;xt 等于 阈值Xthreshold,不奖励也不惩罚。此处阈值Xthreshold 不 做特别规定,视具体情况自行定义。

2.3.2 基于动态贝叶斯的网络攻击威胁度评估

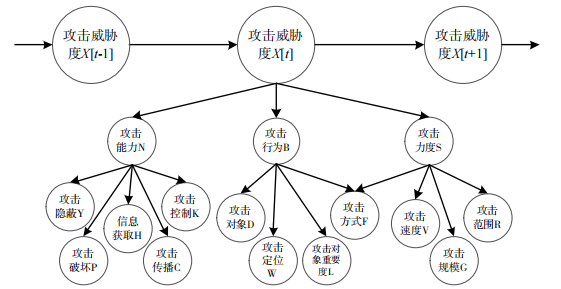

动态贝叶斯 网络攻击威胁度评估,首先确 定攻击威胁各组成要素及其关系,按照要素间关系 建立对应的贝叶斯模型;其次确定贝叶斯模型中各 节点的先验概率和条件概率;最后进行模型推理。

静态贝叶斯模型在时间维度上展开得到动态贝 叶斯模型,如图 5 所示。

图 5 动态贝叶斯网络威胁度评估模型

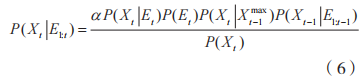

动态贝叶斯网络推理使用滤波算法利用过去结果 和当前证据预测当前结果的推理方法,推理公式为:

(6) 式中:E 代表证据;X代表连接毗邻时间片的节点;t-1 代表过去;t 代表当前;P(Et) 和 P(Xt) 是当前证 据 E 和节点X 的先验概率;P(Xt|Et) 是当前网络滤 波推理前的概率结果;P(Xt-1|E1∶t-1) 和 P(Xt-1|E1∶t) 是 过去和当前网络滤波推理后的概率结果;P(Xt|Ex) 是当前和过去间节点X 的状态转移概率;Xx 是过 去网络滤波推理后最大的概率结果对应的状态; α 是归一化因子。

2.4 网络安全防护智能体训练过程

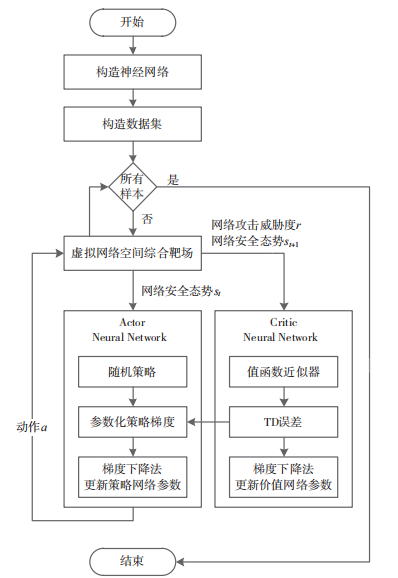

图 6 为网络安全防护智能体训练过程示意图, 训练部分包括网络空间安全态势状态数据和安全防 护动作相关的样本数据集、虚拟网络空间综合靶场仿真环境、Actor 神经网络和 Critic 神经网络。

图 6 中的网络安全防护智能体训练过程描述 如下。

步骤 1: 构 建 Actor 神经 网 络 和 Critic 神经 网 络,形成 Actor 策略网络和 Critic 价值网络。由于网络安全态势数据和网络安全防护动作数据是高维数据,神经网络构建采用深层的深度神经网络。初始化神经网络参数、初始化训练次数、折扣因子、学习率等。

步骤 2:引入实际网络数据,提取网络安全攻击数据,按照动作集合设计中的动作要素构建网络 安全防护动作数据集。

步骤 3: 将网络安全态势数据作为模型的训练数据输入。

步骤 4:Actor 策略网络根据策略函数从动作空 间 A 中选择 actions 输出给仿真环境。

步骤 5:仿真环境执行动作 actions,动作执 行后的网络攻击威胁度和新的网络安全态势做为 Critic 价值网络的输入。

步骤 6:Critic 价值网络计算 TD 误差(td_error),计算 min(td_error2),使用策略梯度算法更新神经网络 参数 w,同时将 TD 误差反馈给 Actor 策略网络。

步骤 7:Actor 策略网络使用策略梯度算法更新 神经网络参数 θ。

步骤 8: 重复步骤 3 至步骤 7, 直至训练结束。

步骤 9:训练结束后, Actor 策略网络参数和学 习到策略函数、Critic 价值网络参数和学习到的价 值函数共同构成智能体 Agent,训练过程获得的目 标策略即是网络安全攻击与其相对应的最优安全防 护策略。

图 6 网络安全防护智能体训练过程

03 结 语

本文针对网络空间安全防护如何智能化的问题 进行研究,探索了深度强化学习解决问题的方法和 过程。将深度强化学习应用在网络空间安全防护领 域,使用深度学习提取网络安全态势数据特征,构 建智能体,由回报函数进行强化学习决策导引,判 断策略和动作好坏,并通过在虚拟网络空间综合靶 场训练学习获得安全防护智能体和最优安全防护策 略集合。智能体在面对网络攻击时根据模型和策略 快速应对,并且强化学习从环境交互过程中学习的 特性可以使智能体在线学习新的策略。

网络空间已成为领土、领海、领空、太空之外 的“第五空间”, 是国家主权的新疆域,国家安全 的重要组成部分。信息网络安全已成为国家信息化 建设的重要基础支撑。信息与通信技(Information and Communications Technology,ICT) 和 人 工 智 能 技术不断取得的新进展,为网络空间安全防护提供了新手段新措施。此外,网络空间安全对抗也将更加智能化,对该领域的研究将会持续深入。

引用本文: 周云, 刘月华 . 基于深度强化学习的智能网络安全防护研究 [J]. 通信技术, 2021, 54(11):2545-2550.