ChatGPT当安全分析师,偶尔会犯错

上周公布的一些实验结果已经证明,当下大热的大型语言模型(LLM)ChatGPT可用于帮助防御者分类潜在安全事件和发现代码中的安全漏洞——虽然这个人工智能(AI)模型并非专为此类活动而训练的。

ChatGPT作为事件响应工具有何效用?在2月15日发布的分析报告中,卡巴斯基事件响应团队主管Victor Sergeev发现,ChatGPT能够识别在被黑系统上运行的恶意进程。Sergeev通过Meterpreter和PowerShell Empire代理感染了目标系统,执行了常见黑客操作,然后用ChatGPT驱动的扫描器针对系统进行扫描。

在描述实验的博客文章中,Sergeev写道,这个LLM识别出系统上运行着两个恶意进程,并精准略过137个良性进程,很大程度上降低了潜在开销。

“ChatGPT成功识别出可疑服务,且没有误报。至于第二项服务,ChatGPT给出了结论,说明为什么该服务应该被归为入侵指标。”

安全研究人员和AI黑客都对ChatGPT投诸极大兴趣,探索这个LLM的弱点;而其他研究人员和网络罪犯则试图黑化这款LLM,以之产出效果更好的网络钓鱼电子邮件或生成恶意软件。

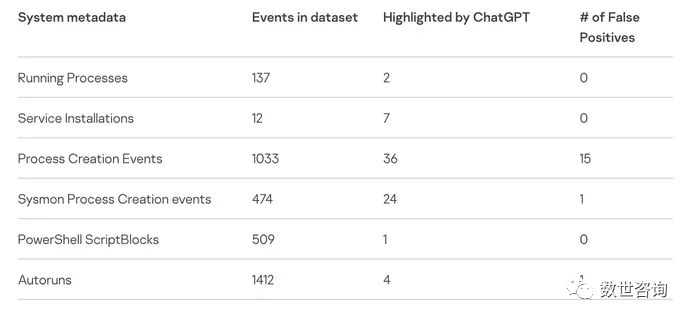

图:ChatGPT发现入侵指标(IoC),误报很少

图:ChatGPT发现入侵指标(IoC),误报很少

不过,安全研究人员也关注这款通用语言模型在特定防御相关任务上的表现。去年12月,数字取证公司Cado Security通过ChatGPT用事件的JSON数据创建了入侵时间线,形成了很不错但并不完全准确的报告。安全咨询机构NCC Group尝试用ChatGPT查找代码中的漏洞,ChatGPT不负所望,但并不总能那么准确。

NCC Group首席科学家Chris Anley得出结论:安全分析师、开发人员和逆向工程师使用LLM需谨慎,尤其是用在LLM能力范围之外的任务之上的时候。

“我确实认为专业开发人员和其他处理代码的人都应该探索ChatGPT及类似模型,但更多的是用作启发而不是追求绝对正确的实际结果。安全代码审核不是我们该用ChatGPT做的事儿,所以期待它一出场就完美亮相多少有点不公平。”

用AI分析IoC

卡巴斯基的实验以询问ChatGPT几款黑客工具的相关情况开始,比如Mimikatz和Fast Reverse Proxy。ChatGPT很好地描述了这些工具,但未能正确识别众所周知的散列值和域名。比如说,WannaCry恶意软件广为流传的一个散列值就没识别出来。

不过,主机恶意代码识别的成功促使Sergeev开始要求ChatGPT创建PowerShell脚本,用以收集系统的元数据和入侵指标并将之提交给ChatGPT。在手动改进了代码之后,Sergeev在被感染的测试系统上使用了该脚本。

这位卡巴斯基分析师用ChatGPT分析了测试系统上总共3500多起事件,找出74个潜在入侵指标,其中17个是误报。实验表明,ChatGPT可以帮助未运行端点检测与响应(EDR)系统的公司收集取证信息,有助于检测代码混淆或逆向工程代码二进制文件。

Sergeev还警告道,不准确是个非常现实的问题。“要注意LLM可能产生的误报和漏报。”他写道,“这终究不过是又一个会产生非预期结果的统计神经网络而已。”

Cado Security的分析则揭示,ChatGPT通常不确定其结果的可信度。“这就是OpenAI自己引发的对ChatGPT的共同关切——ChatGPT会幻听,而且幻听的时候还很自信。”

需澄清合理使用及隐私规则

实验还引出了一些关键问题,有关提交给OpenAI ChatGPT系统的数据。公司已经开始反对用互联网上的信息创建数据集了,Clearview AI和Stability AI等公司正面临诉讼,要求限制其机器学习模型的使用。

另一个问题是隐私。NCC Group的Anley表示,安全专业人员必须确定提交的入侵指标是否会暴露敏感数据,或者提交软件代码供分享是否侵害了公司的知识产权。

“向ChatGPT提交代码是否是个好主意很大程度上取决于所处境况。”他说道,“很多代码都是专有的,受到各种法律保护,所以我不会建议向第三方提交代码,除非获得许可。”

Sergeev发出了类似的警告:使用ChatGPT检测入侵必然会向这个系统发送敏感数据,这就有可能违反公司政策,带来业务风险。”

“使用这些脚本,你将数据发送给OpenAI,包括敏感数据。所以,谨慎点儿,先咨询下系统拥有者。”