谷歌对 6 种现实世界的人工智能攻击进行了分类,以供立即准备

谷歌研究人员已经确定了针对现实世界人工智能系统可能发生的六种特定攻击,发现这些常见的攻击向量表现出独特的复杂性,他们指出,这需要结合对抗性模拟和人工智能主题专业知识的帮助来构建坚实的防御。

该公司在本周发布的一份报告中透露,其专门的 AI 红色团队已经发现了对快速发展的技术的各种威胁,主要是基于攻击者如何操纵驱动 ChatGPT、Google Bard 等生成式 AI 产品的大型语言模型 ( LLM )。

谷歌人工智能红队:道德黑客让人工智能更安全

https://blog.google/technology/safety-security/googles-ai-red-team-the-ethical-hackers-making-ai-safer/

这些攻击很大程度上导致技术产生意外甚至恶意驱动的结果,这可能会导致像普通人的照片出现在名人照片网站上一样良性的结果,但会导致更严重的后果,例如规避安全的网络钓鱼攻击或数据盗窃。

谷歌的调查结果是在其发布安全人工智能框架(SAIF)之后发布的,该公司表示,该框架的目的是在为时已晚之前解决人工智能安全问题,因为该技术已经被快速采用,并随之产生了新的安全威胁。

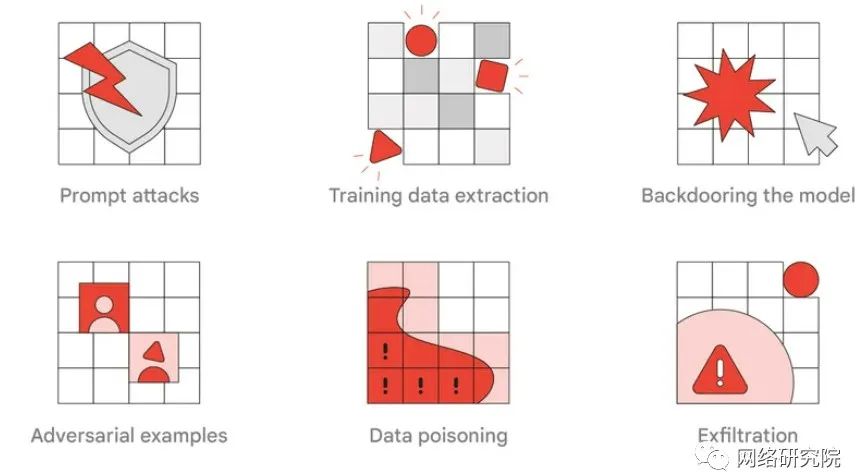

现代人工智能系统的 6 种常见攻击

Google 识别的第一组常见攻击是即时攻击,其中涉及“即时工程”。这个术语指的是制定有效的提示来指导法学硕士执行所需的任务。研究人员表示,这种对模型的影响如果是恶意的,可能会以非预期的方式恶意影响基于 LLM 的应用程序的输出。

一个例子是,如果有人在基于人工智能的网络钓鱼攻击中添加了一个段落,该段落对最终用户来说是不可见的,但可以指示人工智能将网络钓鱼电子邮件分类为合法。这可能会使其绕过电子邮件反网络钓鱼保护,并增加网络钓鱼攻击成功的机会。

该团队发现的另一种类型的攻击称为训练数据提取,其目的是重建模型使用的逐字训练示例,例如互联网的内容。通过这种方式,攻击者可以从数据中提取秘密,例如逐字个人身份信息 (PII)或密码。研究人员写道:攻击者被激励以个性化模型或经过包含 PII 数据训练的模型为目标,以收集敏感信息。

第三种潜在的人工智能攻击是模型后门,攻击者“可能试图秘密改变模型的行为,以使用特定的‘触发’词或特征(也称为后门)产生不正确的输出,在这种类型的攻击中,威胁参与者可以在模型或其输出中隐藏代码以进行恶意活动。

第四种攻击类型称为对抗性示例,是攻击者向模型提供的输入,以产生“确定性但高度意外的输出”。一个例子是,模型可以显示一幅图像,该图像在人眼中清楚地显示出一件事,但模型将其完全识别为另一件事。这种类型的攻击可能是相当良性的(在这种情况下,有人可以训练模型将他或她自己的照片识别为值得包含在名人网站上的照片),也可能是至关重要的,具体取决于技术和意图。

攻击者还可以利用数据中毒攻击来操纵模型的训练数据,从而根据攻击者的偏好影响模型的输出,如果开发人员使用人工智能帮助他们开发软件,这也可能威胁软件供应链的安全。这种攻击的影响可能类似于模型后门。

谷歌专门的人工智能红队识别的最后一种攻击类型是渗透攻击,攻击者可以复制模型的文件表示形式以窃取存储在其中的敏感知识产权。然后,他们可以利用这些信息来生成自己的模型,该模型可用于为攻击者提供定制攻击中的独特功能。

传统安全很重要

谷歌最初的人工智能红队演习为研究人员提供了一些宝贵的经验教训,其他企业也可以利用这些经验教训来防御对人工智能系统的攻击。第一个是,虽然红队活动是一个良好的开端,但组织还应该与人工智能专家合作,进行现实的端到端对抗模拟,以实现最大程度的防御。

事实上,红队演习(即组织招募道德黑客团队尝试渗透其自身系统以识别潜在漏洞)正在成为帮助企业增强整体安全态势的流行趋势。

我们相信,红队将在每个组织应对人工智能系统攻击的准备中发挥决定性作用,并期待共同努力帮助每个人以安全的方式利用人工智能。

然而,团队从另一个教训中得到了一些好消息:传统的安全控制可以有效、显着地降低人工智能系统的风险。

对于保护人工智能模型在其整个生命周期的完整性以防止数据中毒和后门攻击来说尤其如此。

与传统企业系统中的所有其他资产一样,组织还应确保系统和模型得到正确锁定,以防御人工智能攻击。

此外,研究人员指出,组织可以使用与嗅探传统攻击类似的方法来检测对人工智能系统的攻击。

传统的安全理念,例如验证和清理模型的输入和输出,仍然适用于人工智能领域。